Lettura della mente musicale: solo con l’aiuto di scansioni cerebrali e dati EEG è possibile decifrare la musica che il soggetto del test ascolta, come dimostra l’esperienza. Un’intelligenza artificiale adeguatamente addestrata ha selezionato il brano musicale appropriato in base ai segnali neurali non invasivi registrati con un tasso di successo del 71,8%. I risultati potrebbero essere un primo passo sulla strada per leggere il parlato in modo non invasivo dalle onde cerebrali.

La musica è profondamente radicata nella nostra natura. Quando sentiamo suoni familiari, il nostro cervello li riconosce dall’interno di frazioni di secondo. Le misurazioni delle onde cerebrali mostrano che la musica può innescare una serie di segnali, accompagnati da forti emozioni e L’urlo del terrore. Diversi gruppi di ricerca hanno già esaminato ciò che le onde cerebrali possono rivelare quando si ascolta la musica, ad esempio sulle emozioni dei soggetti del test o sulla musica stessa.

Una combinazione di EEG e fMRI

Ian Daly della School of Computer Science and Electronic Engineering dell’Università dell’Essex in Gran Bretagna ha ora dimostrato che le onde cerebrali possono essere utilizzate per determinare quale musica sta ascoltando una persona. Durante Studi precedenti Ad esempio, per leggere il parlato dall’attività cerebrale, utilizzando metodi invasivi come l’elettroencefalografia (EKoG), in cui gli elettrodi sono posizionati nel cranio, Daly ha utilizzato i dati delle misurazioni dell’elettroencefalografia (EEG).

Per aumentare la precisione delle previsioni, Daly ha combinato i dati EEG con le misurazioni della risonanza magnetica funzionale (fMRI), che mostrano il flusso sanguigno nel cervello e quindi forniscono informazioni sulle regioni del cervello che sono particolarmente attive durante l’ascolto di musica in una determinata persona. Il ricercatore ha utilizzato queste informazioni per selezionare con precisione i dati EEG per ulteriori analisi che corrispondevano a queste regioni.

Ricostruire la musica dalle onde cerebrali

I dati provenivano da uno studio precedente che originariamente si concentrava sulle emozioni degli ascoltatori di musica. I 18 soggetti inclusi nell’analisi hanno ascoltato 36 brevi brani di musica per pianoforte mentre la loro attività cerebrale è stata registrata mediante fMRI ed EEG. Daly ha quindi addestrato il modello di deep learning per decodificare i pattern nell’EEG in modo tale da poter ricostruire il rispettivo brano musicale ascoltato dal soggetto del test durante la misurazione.

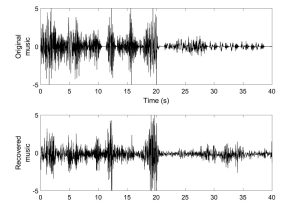

In effetti, il modello è stato in grado di riprodurre parzialmente il tempo, il tempo e l’ampiezza della musica. La somiglianza con i brani musicali originali era abbastanza alta da consentire all’algoritmo di prevedere quale dei 36 brani musicali una persona aveva ascoltato con un punteggio del 71,8%.

differenze individuali

Per convalidare i risultati, Daly ha utilizzato un campione indipendente di altre 19 persone che avevano anche ascoltato i brani musicali corrispondenti. Poiché da questi individui erano disponibili solo dati EEG e nessun dato fMRI, Daly ha utilizzato le informazioni del primo campione per selezionare i dati EEG rilevanti.

“Anche in assenza dei dati fMRI del soggetto, siamo stati in grado di identificare la musica che stavamo ascoltando dai soli dati EEG”, afferma Daly. Tuttavia, osserva, la localizzazione delle reazioni cerebrali legate alla musica varia da persona a persona. Di conseguenza, se il modello non potesse essere alimentato con i dati fMRI della persona, sarebbe meno accurato e raggiungerebbe un tasso di successo di solo il 59,2%.

L’obiettivo a lungo termine: imparare la lingua

Daly vede il suo modello come un primo passo verso obiettivi più grandi. “Questo metodo ha molte potenziali applicazioni”, afferma. “Abbiamo dimostrato che possiamo decodificare la musica, il che suggerisce che un giorno potremmo essere in grado di decodificare il parlato dal cervello”. Gli esperimenti mostrano. Tuttavia, finora questo ha funzionato solo con tecnologie invasive come gli elettrodi cerebrali.

Per le persone con attaccamento che non sono in grado di comunicare con gli altri a causa della paralisi, questo può aprire una porta verso il mondo esterno. “Ovviamente, c’è ancora molta strada da fare, ma speriamo che un giorno, se saremo in grado di decodificare con successo il linguaggio, potremo usarlo per costruire ausili per la comunicazione”, afferma Daly. (Rapporti scientifici, 2023, doi: 10.1038/s41598-022-27361-x)

Fonte: Università dell’Essex