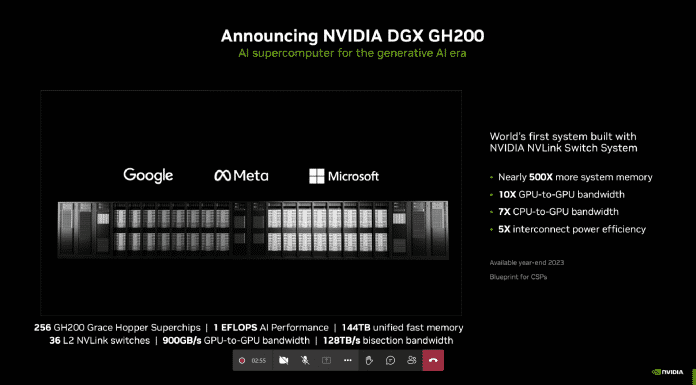

Il produttore di chip Nvidia continua a fare affidamento sulla forza trainante dell’hardware di intelligenza artificiale, che attualmente porta all’azienda miliardi di dollari di profitti. Nel discorso alla fiera Computex IT, il CEO di Nvdia Jensen Huang ha presentato il sistema server DGX GH200, che conta 256 acceleratori Grace Hopper. Sono collegati tramite NVLink e dovrebbero fornire una potenza di calcolo di un exaflop (1 trilione di operazioni al secondo).

I primi sistemi DGX-GH200 dovrebbero essere disponibili entro la fine dell’anno.

(Immagine: Nvidia)

Tuttavia, questa specifica si riferisce al tipo di dati FP8 a 8 bit utilizzato nei calcoli AI e quindi non può essere paragonata alla specifica delle prestazioni dei supercomputer, che sono specificati da numeri in virgola mobile a doppia precisione (FP64). Lì, il sistema DGX-GH200 raggiunge circa 17 petaflop (0,017 exaflop).

Lancio dei client Google, Meta e Microsoft

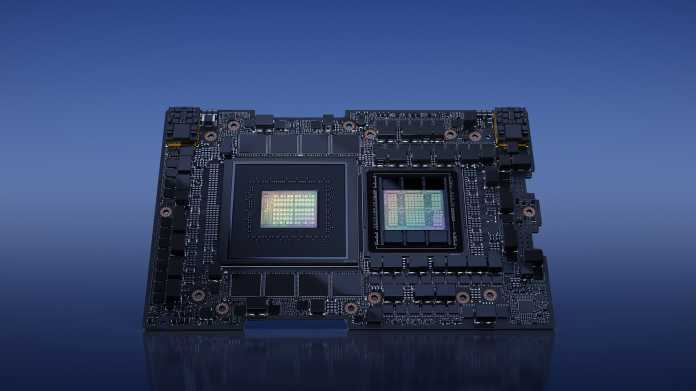

I chip tramoggia Grace GH200 utilizzati sono costituiti da CPU Grace con 72 core ARM Neoverse V2 e GPU H100 con core Tensor, che si trovano in un unico pacchetto. Comunicano tra loro tramite NVLINK a 900 GB/s, così come con altri chip server GH200. In totale, i 256 acceleratori di unità hanno accesso a 144 terabyte di memoria condivisa.

Con Grace Hopper, il processore ARM e la GPU H100 (proprio con la memoria HBM) condividono un pacchetto comune.

(Immagine: Nvidia)

Pertanto, il DGX GH200 è particolarmente adatto per l’addestramento di modelli di grandi dimensioni per applicazioni di intelligenza artificiale generativa. Questi includono modelli linguistici come ChatGPT o generatori di immagini. Non sorprende che i primi clienti siano stati Google, Meta e Microsoft. Ma la stessa Nvidia vuole anche costruire un supercomputer AI chiamato Helios, composto da quattro server DGX-GH200.

Aprire l’architettura del server MGX

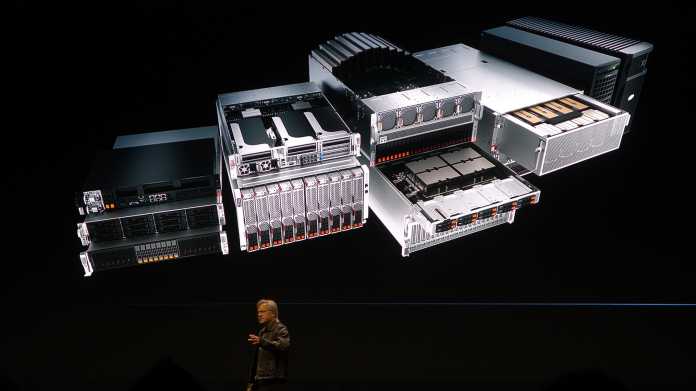

Per i server più piccoli, Nvidia ha anche introdotto l’architettura del server aperto MGX. I produttori di server possono combinare l’intera gamma di GPU di Nvidia con CPU Grace, GH200 o x86 in altezze di una, due o quattro unità. Il produttore di chip collabora con Asrock Rack, Asus, Gigabyte, Pegatron, QCT e Supermicro.

L’architettura del server MGX, ottimizzata per GPU e acceleratore di calcolo, consente vari design.

(Immagine: Nvidia)

(CHH)

“Lifelong beer expert. General travel enthusiast. Social media enthusiast. Zombie expert. Communicator.”